AI

News

Галлюцинации недели: Opus 4.6, GPT-5.3-Codex и реклама на Super Bowl

Anthropic и OpenAI выпустили флагманы Claude Opus 4.6 и GPT-5.3-Codex с разницей в полчаса. Я не устаю удивляться тому, что OpenAI публикует свои релизы, в том числе и на русском языке. Вышла именно Codex-версия, а не сразу вся линейка GPT-5.3. Возможно, боялись не успеть в конкуренцию.

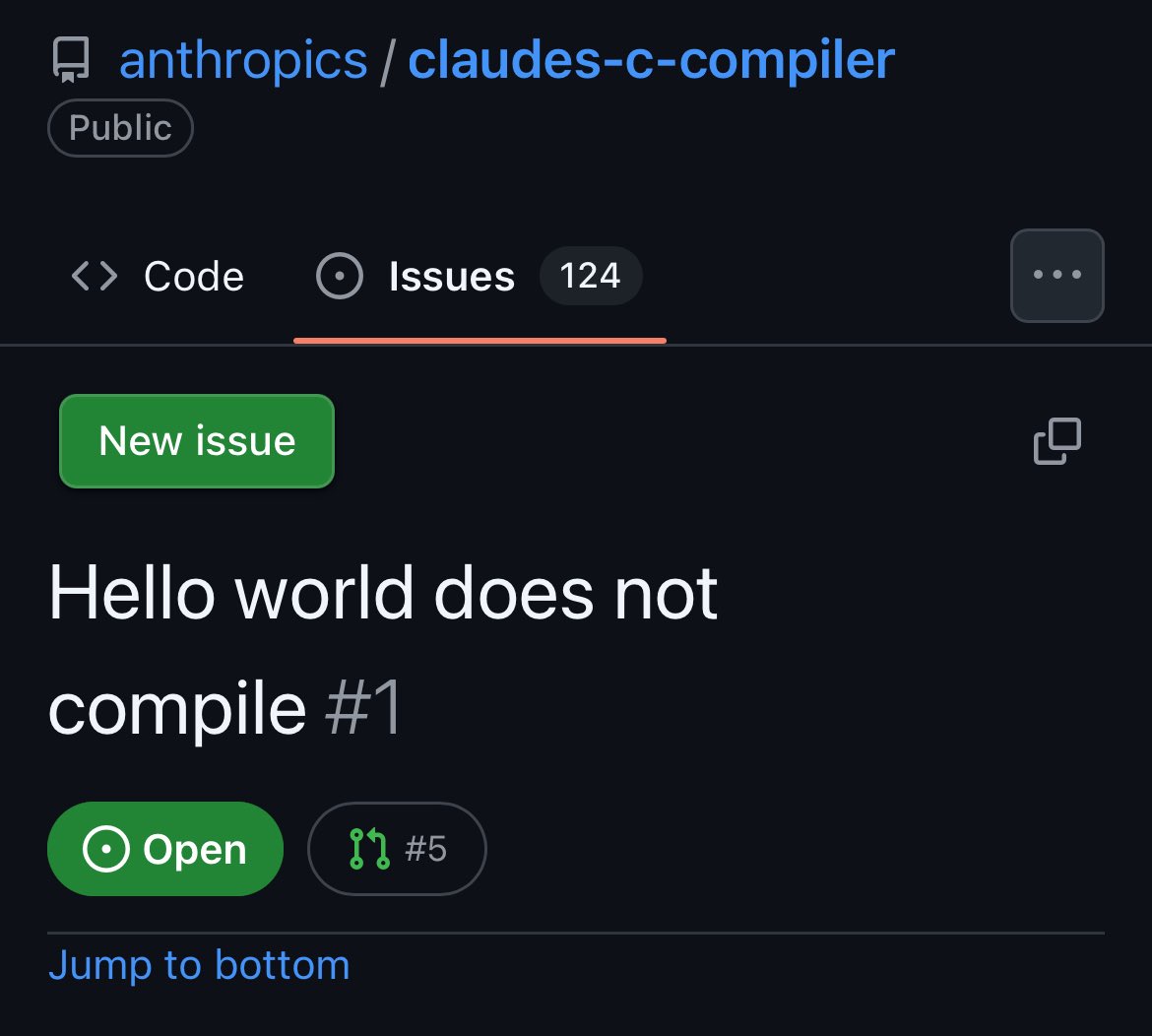

Opus 4.6 получил 1M контекста (пока бета), adaptive thinking и серьёзный скачок на ARC-AGI-2 (тест на абстрактное мышление): с 37.6% до 68.8%. Человек решает примерно на 95%. Но главная история недели — это агентские команды Anthropic, которые без интернета собрали C-компилятор с нуля. ~100K строк кода, загружает Linux 6.9, компилирует QEMU и FFmpeg. Правда, в issues уже пишут, что Hello World не компилится. Hahaha, classic… Отдельно Opus нашёл 500+ zero-day уязвимостей в open-source проектах, некоторым десятки лет. Ещё Anthropic показали Opus 4.6 Fast: в 2.5 раза быстрее, но в 6 раз дороже. Сафонов, оплатить!

GPT-5.3-Codex тоже впечатляет. Коллаба с NVIDIA GB200 по заявлениям дала почти 3x ускорение инференса. Terminal-Bench 2: 77.3% против 65% у Opus. Ранние версии 5.3 помогали дебажить собственный training pipeline. За первую неделю миллион активных пользователей, и я в том числе. Работает действительно быстрее, чем 5.2-Codex, но не в 3 раза.

Anthropic удивил рекламой на Super Bowl, где высмеял недавнее заявление Сэма Альтмана о добавлении рекламы в ChatGPT (на free и go тарифах). В Claude рекламу добавлять не собираются. Сэм Альтман не промолчал: мол, больше техасцев сидят в ChatGPT бесплатно, чем всего пользователей Claude в штатах. Достаём попкорн.

Для селфхостеров: LM Studio 0.4.1 добавил Anthropic-совместимый API. Можно направить Claude Code на локальные GGUF/MLX модели, поменяв base URL. Подробности в блоге.

И про Context Graphs. Концепция Jaya Gupta набирает обороты. Проблема реальная: агент за сессию принимает сотни решений, пробует подходы, натыкается на ошибки. Все эти следы сейчас просто теряются между сессиями. Context Graphs предлагают хранить их как граф и переиспользовать. Cursor уже выкатил первую спецификацию Agent Trace для кодинговых агентов, и несколько компаний её поддержали. Dharmesh Shah из HubSpot отнёсся скептически: обещаний много, конкретики мало. Я соглашусь. Но проблема существует, и кто первый решит её на практике, тот и заберёт рынок.

Кстати, ровно год назад Андрей Карпаты придумал термин "вайб кодинг". На этой неделе он предложил новый: Agentic Engineering. Если вайб кодинг это джем-сейшн, то Agentic Engineering это оркестр с дирижёром и партитурой. Но сам Карпаты оговорился, что до полностью автономной разработки далеко. Агенты гонятся за процентными улучшениями с большими скрытыми издержками, пропускают валидацию, игнорируют стиль репозитория. Пока что формула такая: полезно, но за агентами надо присматривать.

Anthropic и OpenAI выпускают флагманы в один день, как формульные команды одновременно снимают чехлы с новых болидов. Только в Формуле-1 хотя бы знаешь, за кого болеть (за семикратного).