AI

LLM

Basis

MoE vs. SSM: Два пути из «Тирании Квадрата» Трансформеров

Архитектура Трансформеров, без сомнения, гениальна. Ее механизм внимания позволил моделям увидеть связи и зависимости в данных с невиданной ранее глубиной. Однако у этой конструкции есть врожденный порок, фундаментальный изъян, который из технической детали превратился в главный тормоз на пути к AI, способному на настоящее глубинное понимание. Имя этому пороку — «Тирания Квадрата».

Технически это описывается как сложность O(n²): для обработки последовательности длиной n токенов требуется n*n операций. На практике это означает, что удвоение длины контекста в четыре раза увеличивает объем вычислений. Это не просто дорого — это стена, в которую мы уперлись на полном ходу.

Чтобы прочувствовать масштаб проблемы, давайте проведем мыслительный эксперимент. Представьте, что вы — «корпоративный археолог». Ваша задача — проанализировать годовой архив Slack и Confluence вашей компании, состоящий из миллионов токенов, чтобы найти первопричину провала крупного проекта. Вам нужно отследить смену требований, выявить скрытые конфликты и найти ту самую «нить Ариадны» в этом гигантском лабиринте данных. Классический Трансформер здесь — как археолог с идеальной лупой, но страдающий тяжелой формой амнезии. Он безупречно проанализирует одно-единственное сообщение, поймет его нюансы и контекст в пределах своего крошечного окна внимания. Но он абсолютно не в состоянии удержать в голове всю картину и связать решение, принятое в январе, с его последствиями в сентябре.

Сам механизм внимания, где каждый токен должен «поговорить» с каждым, можно назвать «Королевским советом». Он невероятно эффективен для малого круга советников, где все участники могут общаться напрямую и вырабатывать оптимальное решение. Но когда этот «совет» разрастается до сотен тысяч, а затем и миллионов членов, он становится катастрофически дорогим и неэффективным, приводя к полному параличу системы. Мы научились строить гениальных спринтеров, но задача требует от нас марафонцев. И эта тирания квадратичной сложности заставляет всю индустрию искать выход.

Экономика Неустойчивости

«Тирания Квадрата» — это не просто элегантная формула из учебника по Computer Science, а вполне реальная стена, которая превратила наш технологический прорыв в экономический тупик. Важно понимать: поиск замены Трансформерам — это не академическое упражнение и не погоня за модой. Это гонка на выживание, потому что экономика их масштабирования зашла в тупик.

Почему вся индустрия так отчаянно ищет выход прямо сейчас? Потому что продолжать старый путь — значит обанкротиться.

Каждый новый процент качества в SOTA (State-of-the-Art) моделях стоит экспоненциально дороже. Затраты на обучение и инференс флагманских моделей исчисляются уже не десятками, а сотнями миллионов долларов. Индустрия достигла плато, где дальнейшее масштабирование «в лоб» — простое увеличение числа параметров и объема данных — становится экономически безумным. Мы научились строить все более мощные двигатели, но цена их постройки и заправки растет так быстро, что скоро их смогут позволить себе лишь единицы.

Это поставило перед архитекторами самый главный вопрос: как создать модели, которые будут не просто больше, а фундаментально умнее и эффективнее? Как вырваться из ловушки, где каждый шаг вперед требует все больше вычислительной мощности в геометрической прогрессии? Ответ пришел не в виде единого «решения», а в форме двух совершенно разных, но одинаково перспективных архитектурных философий, которые предлагают свой путь из тирании.

"Разделяй и Властвуй" — Философия Mixture-of-Experts (MoE)

Первый путь из этой тирании — это философия Mixture-of-Experts (MoE). В своей основе она пытается воссоздать в кремнии один из самых эффективных принципов нашего мозга: избирательное внимание и специализацию нейронных контуров. Вместо того чтобы задействовать всю гигантскую нейросеть для обработки каждого входящего токена, MoE-модели используют специальную «гейт-сеть» (или «роутер»), которая направляет каждый токен только к нескольким наиболее подходящим «экспертам» — небольшим, специализированным подсетям. Это как если бы для решения математической задачи мозг активировал только нейронные цепи, отвечающие за логику, оставляя в покое те, что отвечают за распознавание лиц. Такой подход радикально сокращает объем вычислений для каждой конкретной задачи, позволяя при этом наращивать общую «емкость знаний» модели до триллионов параметров.

Вернемся к нашему корпоративному археологу. Вооруженный MoE-моделью, он перестает быть одиночкой с лупой. Теперь он — руководитель команды узких специалистов. Когда на его стол попадает фрагмент кода, модель активирует «эксперта по Python». Когда он анализирует юридический документ — в дело вступает «эксперт по праву». Эта архитектура идеально понимает суть каждого отдельного документа, достигая в этом невероятной глубины. Но, как и в реальной команде, у нее есть слабое место: она все еще ограничена в своей способности связать документ №1 с документом №5000, если они относятся к совершенно разным областям и требуют разных экспертов. Проблема квадратичной сложности внутри контекстного окна никуда не делась.

К сентябрю 2025 года этот подход уже перестал быть экзотикой и породил целую плеяду мощнейших моделей, определяющих ландшафт индустрии:

- MiniMax-M1 (MiniMax): Как мы уже обсуждали в статье, это знаковая гибридная модель, сочетающая MoE-архитектуру (456 млрд общих параметров при 46 млрд активных) с инновационным механизмом внимания "Lightning Attention". Ее главное преимущество — гигантское контекстное окно в 1 миллион токенов, что делает ее одной из самых мощных открытых моделей для анализа сверхдлинных документов.

- DeepSeek V3.1 (DeepSeek AI): Выпущенная в августе 2025, эта модель примечательна не только гибридной MoE-архитектурой, но и очень гибкой лицензией MIT. Ее ключевая особенность — два режима работы: быстрый для простых задач и глубокий для сложных рассуждений, что делает ее гибким инструментом.

- Llama 4 Maverick & Scout (Meta): Новейшее поколение моделей от Meta, которое полностью перешло на MoE и стало нативно мультимодальным (текст, изображения, видео). Llama 4 Scout особенно выделяется рекордным контекстным окном до 10 миллионов токенов, открывая возможности для анализа огромных массивов данных вроде годовых отчетов.

- GPT-OSS (OpenAI): Знаковый возврат OpenAI к выпуску моделей с открытыми весами. Это семейство MoE-моделей (120 и 20 млрд параметров) под лицензией Apache 2.0 стало хитом в корпоративной среде, позволяя разворачивать мощный AI на собственной инфраструктуре без компромиссов в конфиденциальности.

- Qwen3 (Alibaba): Серия передовых открытых MoE-моделей, которая позиционируется как прямой конкурент ведущим проприетарным системам вроде GPT-4o. Благодаря высокой производительности и лицензии Apache 2.0, Qwen3 стала одним из столпов для бизнеса и научных исследований в open-source сегменте.

В комментариях к предыдущей статье о локальном запуске LLM пользователи высоко оценили последние две модели, отметив, что за ними будущее в сфере локального применения.

Все они используют один и тот же принцип: масштабировать общее количество параметров для достижения беспрецедентного объема знаний, сохраняя при этом количество активных параметров на приемлемом уровне для снижения стоимости инференса. Важно понимать: впечатляющие контекстные окна в некоторых из этих моделей достигаются не самой MoE-архитектурой, а дополнительными инновациями, такими как новые механизмы внимания, которые работают в паре с MoE. Однако за эту элегантность приходится платить. Главный «инженерный демон» MoE — это колоссальные требования к VRAM. Чтобы модель работала, в память GPU необходимо загрузить всех экспертов, даже если для конкретного токена будет задействовано всего несколько из них. Это делает инференс крайне ресурсоемким и создает серьезный барьер для широкого развертывания. MoE решает проблему вычислительной сложности, но создает проблему сложности инфраструктурной.

"Помнить Всё" — Философия State Space Models (SSM)

Философия «разделяй и властвуй» радикально повышает эффективность, но оставляет без ответа другую, не менее острую боль: как эффективно работать с контекстом, который измеряется не тысячами, а миллионами токенов? Вспомните нашего археолога. Если MoE-модель вооружает его командой узких специалистов, то она по-прежнему не дает ему возможности связать воедино два совершенно разных документа, между которыми лежит годовой ворох данных. Проблема квадратичной сложности внутри окна внимания никуда не исчезла.

Именно здесь на сцену выходит совершенно иная философия — философия непрерывной памяти, воплощенная в моделях пространства состояний (State Space Models, SSM). Эта архитектура, по сути, подражает тому, как работает наше собственное сознание. Мы не перебираем все воспоминания из прошлого, чтобы сформировать новую мысль; вместо этого весь наш прошлый опыт сжимается в одно непрерывное "состояние" или "поток сознания", который влияет на наше восприятие настоящего момента. SSM-модели реализуют этот принцип в кремнии, обрабатывая данные с линейной сложностью (O(n)), что окончательно свергает «Тиранию Квадрата».

Для нашего археолога SSM — это не просто новый инструмент, это прорыв. Вместо того чтобы перечитывать весь архив в поисках связи между каждыми сообщениями, модель читает весь массив данных от начала до конца, как одну длинную историю, постоянно обновляя свое внутреннее «понимание» проекта. Она способна заметить то самое сообщение, отправленное в январе, и связать его с последствиями, которые проявятся в сентябре — именно так она находит ту самую нить в хаосе миллионов документов. Этот подход превращает проблему поиска в непрерывное обновление знания, а не в перебор комбинаций.

Эффективность SSM-моделей — не просто теория. Первый большой прорыв в этом направлении был достигнут с появлением архитектуры Mamba. Ее ключевая инновация — механизм «селективного пространства состояний», который позволяет модели динамически адаптировать свои параметры в зависимости от входящего потока данных. Говоря проще, Mamba умеет избирательно фокусироваться на важной информации и отбрасывать нерелевантный «шум», что делает ее идеальной для работы с экстремально длинными последовательностями, где ключевые сигналы могут быть похоронены под тоннами мусора.

Появление Mamba открыло совершенно новый горизонт. Если MoE-модели фокусируются на эффективности обработки токенов, то SSM — на эффективности памяти. Линейная сложность открывает дорогу к анализу бесконечных потоков данных, что делает их идеальными для таких доменов, как обработка аудио, анализ логов или расшифровка генома.

К сентябрю 2025 года эта философия уже породила целое семейство мощных архитектур:

- Mamba-2: Это не коммерческий продукт, а фундаментальная архитектура с открытым исходным кодом, которая служит технологической базой для всего SSM-направления. Mamba-2 является самой совершенной «чистой» SSM-моделью, демонстрируя производительность на уровне трансформеров при значительно большей эффективности.

- Nemotron-H (NVIDIA): Это семейство гибридных моделей (Mamba-Transformer), разработанное NVIDIA для достижения максимальной эффективности инференса. Заменив до 92% дорогостоящих слоев внимания на сверхбыстрые блоки Mamba-2, инженеры добились 3-кратного ускорения по сравнению с аналогичными трансформерами (например, Llama 3.1), сохранив при этом высокое качество. Благодаря оптимизации под GPU NVIDIA, Nemotron-H стал ключевым инструментом для задач, требующих высокой пропускной способности и работы с длинным контекстом.

- Jamba (AI21 Labs): Первый широко известный «гибридный монстр», который успешно объединил слои SSM (на базе Mamba), классические блоки Трансформеров и MoE-слои. Он доказал жизнеспособность такого подхода, взяв лучшее из трех миров: эффективность SSM, мощь рассуждений Трансформера и широту знаний MoE. Его характеристики (52 млрд общих параметров при 12 млрд активных, контекст 256к) и способность уместиться на одной 80-гигабайтной GPU-карте стали яркой демонстрацией инженерного будущего.

Более того, философия SSM уже выходит за пределы одних лишь языковых моделей. Анализ недавних публикаций показывает, что Mamba становится новым универсальным «LEGO-блоком» для самых разных доменов. Например, VG-Net использует ее для обнаружения изменений на спутниковых снимках, а Mamba-CNN объединяет ее со сверточными сетями для анализа изображений. Это говорит о том, что SSM — не просто замена Трансформерам, а новый фундаментальный компонент, который позволит инженерам создавать невероятно эффективные модели для самых разных задач.

Перекресток и цена сложности

Итак, мы стоим на перекрестке. Перед нами два четко очерченных пути, ведущих из-под ига «Тирании Квадрата». Первый путь, MoE, масштабирует знания, создавая колоссальную модель-энциклопедию из ансамбля узких специалистов, которые знают все в своей области. Второй путь, SSM, масштабирует контекст, позволяя модели помнить и связывать воедино гигантские объемы информации, не теряя ту самую «нить Ариадны». Оба пути ведут к линейной сложности вычислений и открывают новые горизонты. Но, как знает любой инженер, в нашем мире не бывает бесплатных обедов. За все нужно платить.

За каждой новой элегантной архитектурой скрываются свои «инженерные демоны» — практические проблемы, которые с лихвой компенсируют теоретическое изящество и которые приходится укрощать командам разработчиков «в траншеях».

Боль MoE: Как мы уже упоминали, главный демон этой архитектуры — гигантский объем VRAM, необходимый для инференса. Даже если для обработки одного токена вы используете лишь 10% от общего числа экспертов, вам все равно придется загрузить все 100% параметров в память видеокарты. Это все равно что для вызова одного специалиста арендовать целый бизнес-центр со всеми его обитателями. Кроме того, MoE-модели значительно сложнее в обучении. Возникает проблема балансировки нагрузки: нужно следить, чтобы роутер не отправлял все запросы к одним и тем же «популярным» экспертам, оставляя других без дела. Это требует сложных алгоритмов и увеличивает накладные расходы на коммуникацию между частями модели.

Боль SSM: С другой стороны, SSM-модели — это «новые дети на районе». Несмотря на всю свою мощь и потенциал, на сентябрь 2025 года они пока не имеют такой обширной и зрелой экосистемы, как Трансформеры. Для инженера это означает меньше готовых, оптимизированных библиотек, меньше готовых рецептов и меньше накопленного сообществом опыта по решению типовых проблем. Внедрять SSM — это как строить на основе новейшего, сверхэффективного, но еще не до конца изученного композитного материала, в то время как вся индустрия десятилетиями оттачивала работу с железобетоном.

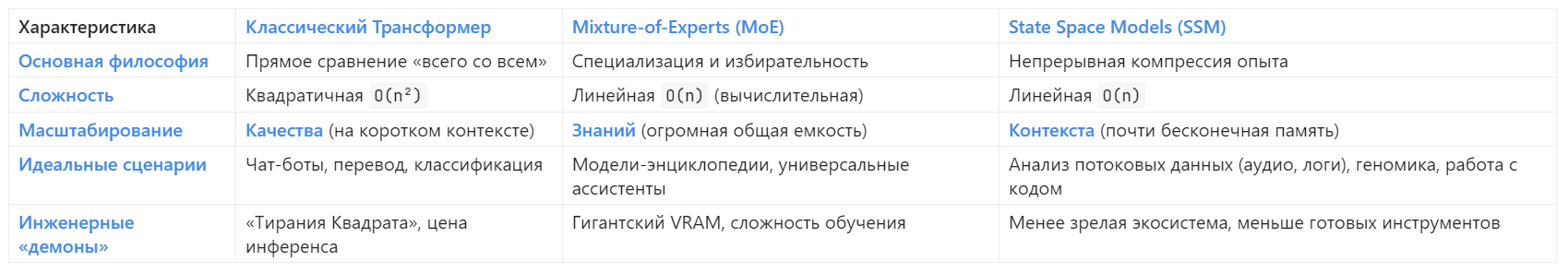

Чтобы наглядно оценить этот перекресток и сделать осознанный выбор, давайте сведем ключевые различия в одну таблицу.

Закат Империи и новая эра модульности

Мы наблюдаем не просто эволюцию, а конец эпохи, где одна-единственная архитектура доминировала во всем. Трансформер был как римский акведук — гениальная, монолитная конструкция, которая решила одну грандиозную задачу и доставила «воду» (внимание) во все части империи данных. Это было настолько мощное и универсальное решение, что на долгие годы оно стало синонимом самой идеи state-of-the-art AI. Но мы больше не строим акведуки. Задачи стали сложнее, разнообразнее, а монолитный подход исчерпал себя, упершись в стену экономической и вычислительной реальности.

Наступает эра модульности, где AI-архитекторы будут, как из LEGO, собирать модели из разных фундаментальных блоков, подгоняя архитектуру под конкретную задачу. Будущее AI — это не новый монолит, а сложная, гетерогенная система.

Если продолжать аналогию, то мы переходим от строительства акведуков к проектированию современного города. В этом городе есть место для всего. Здесь есть высоченные небоскребы (MoE), которые позволяют сконцентрировать огромное количество «жителей» (знаний) на одном пятачке земли. Есть сверхскоростные магистрали (SSM), которые с линейной эффективностью связывают отдаленные районы, позволяя информации перемещаться на огромные расстояния без пробок. И, конечно, в этом городе остаются уютные парки (классическое внимание) — небольшие пространства, где можно решать локальные задачи с максимальным качеством и комфортом.

Никто в здравом уме не будет строить город только из небоскребов или только из магистралей. Сила города — в синергии его разнородных частей. Точно так же сила будущих AI-систем будет заключаться не в выборе одного «правильного» пути, а в умном комбинировании. Будущее за гибридами, которые умеют сочетать сильные стороны разных подходов, создавая архитектуры, которые одновременно и знают много, и помнят долго, и рассуждают точно.

Компас архитектора: четыре правила новой эры

Как же не заблудиться на этом перекрестке, где старая империя рухнула, а новые государства только формируются? Как архитектору AI-систем сделать правильный выбор сегодня? Вместо сложной теории, я предлагаю простой компас — четыре эвристики, квинтэссенцию всего нашего анализа, которая поможет вам выбрать правильный путь.

- Правило Максимального Качества: Ваша задача требует бескомпромиссной точности на коротком или среднем контексте (скажем, до 32 тысяч токенов)? Это классические задачи вроде чат-ботов, классификации или перевода. Не спешите хоронить старую гвардию. Трансформер все еще ваш король. Его экосистема наиболее зрелая, инструменты отточены до блеска, а качество на коротких дистанциях до сих пор является золотым стандартом.

- Правило Бездонных Знаний: Вам нужна модель-энциклопедия, способная с высокой точностью отвечать на максимально разнородные запросы из разных областей знаний? Ваш выбор — MoE. Эта архитектура даст вам доступ к колоссальному объему «пассивных» знаний при относительно низких (в сравнении с гигантскими монолитными моделями) затратах на инференс. Но будьте готовы к плате за эту мощь — высокому VRAM-футпринту.

- Правило Бесконечной Памяти: Ваша задача — анализ длинных последовательностей, будь то код, аудио, временные ряды или логи серверов? Вы работаете с потоковыми данными, у которых нет четкого конца? Смотрите в сторону SSM. Его линейная сложность — это не просто преимущество, это единственный физически и экономически осмысленный путь к решению таких проблем.

- Правило Гибридов: Ваша задача сложна и многогранна? Она требует и глубоких знаний, и длинного контекста, и точных рассуждений? Не ищите "серебряную пулю" в одной архитектуре. Изучайте гибриды вроде Jamba. Будущее за комбинированием. Именно на стыке разных подходов рождаются самые эффективные и прорывные решения.

Тирания Квадрата свергнута. Простые времена, когда любая проблема решалась добавлением еще одного легиона к армии Трансформеров, закончились. Мы вступаем в эпоху гибридных войн и асимметричных ответов, где стратегия и элегантность решения важнее размера. Старый императив «масштабируй» мертв. Готовы ли мы к новому — «комбинируй»?

Оставайтесь любопытными.