AI

Basis

Карта мира искусственного интеллекта: Гид по технологиям, которые меняют реальность

Мы живем в эпоху AI. Эти две буквы преследуют нас повсюду: из новостных заголовков, маркетинговых брошюр и описаний каждого второго стартапа. Но за этим коротким и уже набившим оскомину акронимом скрывается целая вселенная технологий: машинное обучение (ML), глубокое обучение (DL), нейронные сети, обработка естественного языка (NLP), компьютерное зрение (CV)... В этом калейдоскопе терминов легко потеряться даже техническому специалисту, не говоря уже об остальных. Хайп смешивается с реальностью, а возможности — с откровенными мифами.

Предлагаю навести порядок в знаниях. Эта статья — ваша персональная карта и путеводитель по миру современного искусственного интеллекта. Моя цель — не просто перечислить определения, а показать, как из отдельных, казалось бы, разрозненных «инструментов» и «музыкантов» собирается невероятно мощный и слаженный «оркестр», способный решать задачи, которые еще десять лет назад казались научной фантастикой. Мы разберем не только «что» и «как», но и «почему» и «какой ценой». К концу этого путешествия у вас в голове должна сложиться целостная, структурированная картина мира AI, которая позволит вам смотреть на технологии насквозь.

Эта статья для всех, кто хочет перестать путать теплое с мягким, а машинное обучение с Терминатором, и наконец-то понять, как на самом деле устроен мир современных AI-технологий.

Закладываем фундамент: AI, ML, DL — главная матрёшка

Прежде чем строить небоскреб, нужно заложить прочный фундамент. В мире AI этот фундамент — четкое понимание трех ключевых терминов: AI, ML и Deep Learning. Можно сравнить с матрешкой. Одна концепция вложена в другую, и важно не путать самую большую куклу с самой маленькой.

Как я уже писал в своей статье «Что такое «искусственный интеллект» на самом деле», разделение реальности и мифов начинается именно здесь.

- AI (Искусственный интеллект) — это самая большая матрёшка. Это общее название для всей научной области, цель которой — заставить машины выполнять задачи, требующие человеческого интеллекта. Концепция AI родилась еще в 50-х годах XX века и включает в себя всё: от систем, основанных на жестких правилах (экспертные системы 80-х), до современных нейросетей. Если машина играет в шахматы, распознает речь или советует вам фильм — это всё подпадает под зонтичный термин AI.

- ML (Машинное обучение) — матрёшка поменьше, вложенная в AI. Это главный двигатель современного AI. Ключевое отличие ML от классического программирования в том, что мы не пишем жесткие инструкции «если А, то Б». Вместо этого мы создаем алгоритм и «скармливаем» ему огромное количество данных, на которых он самостоятельно обучается находить закономерности. Система не запрограммирована, а натренирована. Это фундаментальный сдвиг парадигмы.

- DL (Глубокое обучение) — самая маленькая, но и самая мощная матрёшка внутри ML. Это подраздел машинного обучения, который использует для тренировки особые архитектуры — глубокие нейронные сети (о них чуть позже). Именно благодаря прорывам в Deep Learning мы сегодня видим такие чудеса, как фотореалистичные изображения по текстовому описанию, почти идеальный перевод в реальном времени и чат-ботов, способных вести осмысленный диалог.

Итак, запомним: любой Deep Learning — это Machine Learning, а любой Machine Learning — это AI. Но не наоборот. Когда кто-то говорит «мы внедрили AI», стоит уточнить, о какой именно матрёшке идет речь. Чаще всего это будет ML, а на острие прогресса — DL.

Рецепт революции: Три ингредиента, которые изменили всё

Логичный вопрос: если концепция AI существует уже 70 лет, почему «взрыв» произошел именно в последние 10-15 лет? Ответ кроется в идеальном шторме — совпадении трех ключевых факторов, которые стали рецептом текущей технологической революции.

- Ингредиент №1: Большие данные (Big Data). Машинное обучение, как мы выяснили, питается данными. И в XXI веке человечество стало генерировать эти данные в промышленных масштабах. Соцсети, смартфоны, IoT-устройства, оцифрованные архивы — всё это создало невиданные ранее океаны информации. Данные — это топливо для AI. Без них даже самый совершенный алгоритм — это мощный двигатель без капли бензина.

- Ингредиент №2: Вычислительная мощность (GPU). Глубокое обучение требует колоссальных вычислений. Нейронные сети состоят из миллионов (а теперь и миллиардов) параметров, которые нужно постоянно пересчитывать в процессе тренировки. И здесь на помощь неожиданно пришла игровая индустрия. Оказалось, что графические процессоры (GPU), созданные для отрисовки сложной 3D-графики, идеально подходят для параллельных вычислений, необходимых нейросетям. Их архитектура, заточенная под одновременное выполнение тысяч простых операций (матричных умножений), стала теми самыми «мускулами», которые позволили AI-моделям нарастить сложность и мощь.

- Ингредиент №3: Алгоритмические прорывы. Имея топливо (данные) и мускулы (GPU), не хватало только эффективного «двигателя». И он появился. Начиная с 2012 года (архитектура AlexNet, победившая в конкурсе ImageNet) и заканчивая революцией 2017 года (статья «Attention Is All You Need» от Google, представившая архитектуру Трансформеров), произошла серия фундаментальных прорывов в самих алгоритмах. Трансформеры, в частности, стали тем самым гейм-ченджером для работы с последовательностями (текстом, речью), который лежит в основе всех современных больших языковых моделей вроде GPT-4 и Claude.

Эти три компонента — данные, железо и алгоритмы — создали синергию, которая и привела нас в сегодняшний день.

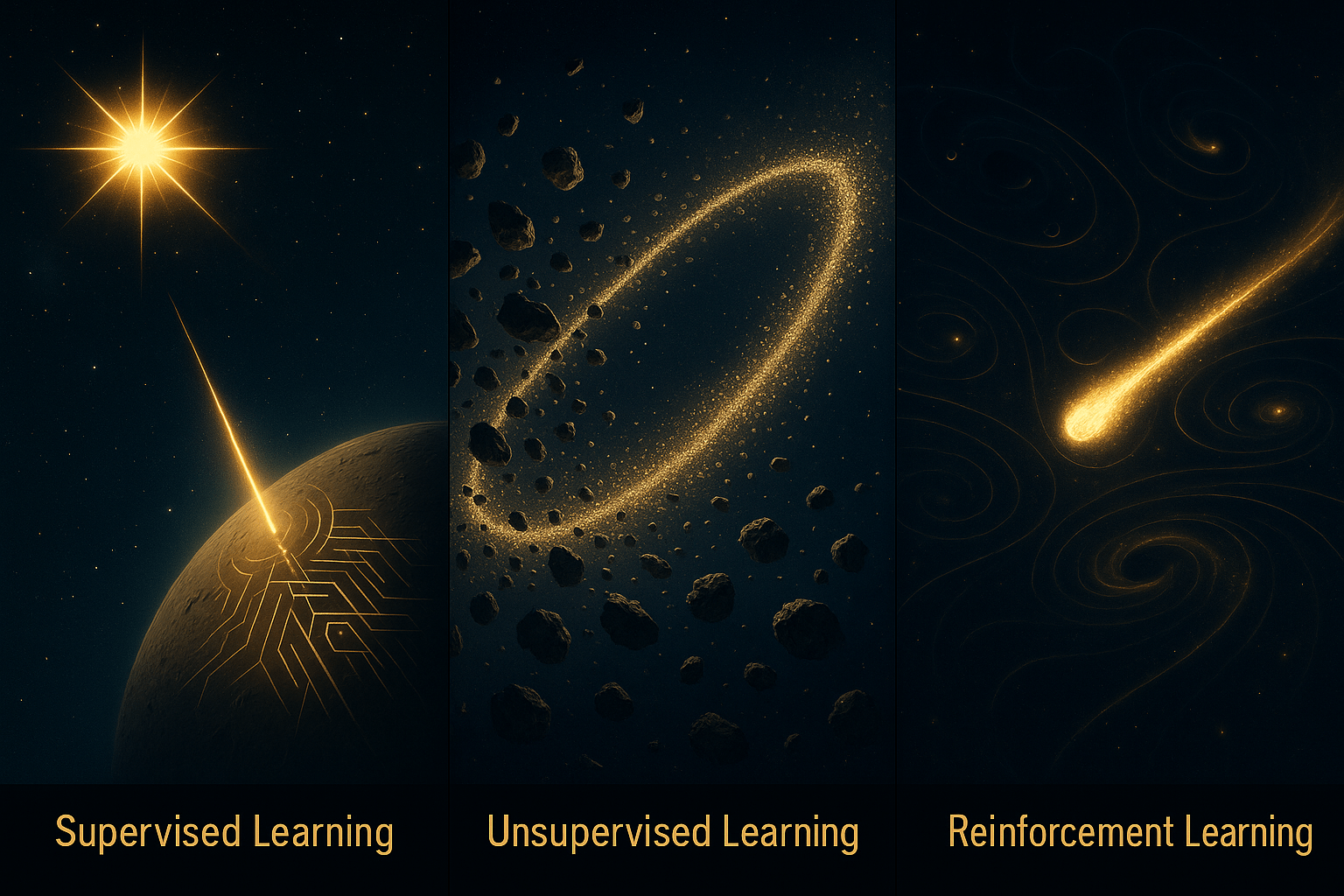

Три способа обучения: Как «репетирует» наш оркестр

Итак, у нас есть «оркестр» (модель) и мы хотим научить его хорошо «играть». В машинном обучении есть три основных подхода к этому «обучению», три разные педагогические методики.

- Обучение с учителем (Supervised Learning). Это самый распространенный и понятный метод. Представьте, что мы даем нашему «музыканту» партитуру, где каждая нота уже подписана и проверена. В мире данных это означает, что у нас есть размеченный датасет: тысячи картинок с подписью «кошка» или «собака», миллионы писем с пометкой «спам» или «не спам». Модель смотрит на входные данные (картинку) и на правильный ответ (метку), а затем пытается настроить свои внутренние параметры так, чтобы ее собственный ответ совпал с «правильным». Она повторяет это миллионы раз, пока не научится делать это с высокой точностью.

- Обучение без учителя (Unsupervised Learning). А что если у нас нет «партитуры»? Что если у нас есть огромный массив данных, но никто их не размечал? Здесь в игру вступает обучение без учителя. Аналогия с оркестром: музыканты просто собираются вместе и начинают импровизировать, слушая друг друга. Постепенно они сами, без дирижера, находят гармоничные сочетания и группируются по звучанию. На практике это означает, что алгоритм сам ищет скрытые структуры и закономерности в неразмеченных данных. Классический пример — кластеризация: система может автоматически сгруппировать ваших клиентов по покупательскому поведению, даже если вы изначально не задавали никаких критериев.

- Обучение с подкреплением (Reinforcement Learning). Это самый «человечный» способ обучения, основанный на методе проб и ошибок. Представьте дирижера, который не дает партитуру, а просто говорит «хорошо» или «плохо» после каждого сыгранного фрагмента. Алгоритм (или «агент») совершает некое действие в определенной среде (например, делает ход в игре) и получает в ответ «награду» или «штраф». Его цель — максимизировать итоговую награду. Именно так обучали AlphaGo от DeepMind, которая обыграла чемпиона мира в го. Она сыграла миллионы партий сама с собой, постепенно вырабатывая выигрышные стратегии.

Мозг системы: Что такое нейронные сети?

Мы уже несколько раз упомянули нейронные сети как основу для Deep Learning. Давайте заглянем под капот и разберемся, что это такое, на интуитивном уровне.

Нейронные сети (Neural Networks) — это вычислительные модели, вдохновленные структурой человеческого мозга. Они состоят из множества соединенных между собой «нейронов», которые организованы в слои. Каждый нейрон получает сигналы от нейронов предыдущего слоя, производит над ними простое математическое преобразование и передает результат дальше.

- Входной слой получает исходные данные (например, пиксели картинки).

- Скрытые слои (их может быть от одного до сотен) производят основную «магию», находя все более сложные и абстрактные паттерны.

- Выходной слой выдает финальный результат (например, вероятность того, что на картинке кошка).

«Глубокое обучение» (Deep Learning) и означает использование сетей с большим количеством (глубиной) скрытых слоев.

Среди всего многообразия архитектур нейросетей стоит выделить одну, которая отвечает за бум генеративного AI:

Генеративно-состязательные сети (GANs). Это гениальная концепция, которую можно описать как «творческий дуэт» из двух нейросетей.

- Генератор: Эта сеть — «фальшивомонетчик». Ее задача — создавать новые данные, неотличимые от настоящих (например, рисовать лица людей, которых никогда не существовало).

- Дискриминатор: Эта сеть — «эксперт-криминалист». Ее задача — смотреть на изображение (реальное или сгенерированное) и определять, подделка это или нет.

Они обучаются вместе в постоянной борьбе: Генератор старается обмануть Дискриминатора, а Дискриминатор — поймать его на лжи. В результате этого состязания обе сети становятся невероятно хороши в своих задачах. Именно GAN'ы долгое время были главной технологией для генерации фотореалистичных изображений.

Оркестр в сборе: Технологии для решения реальных задач

Теперь, когда у нас есть все компоненты, давайте посмотрим, как наш «оркестр» исполняет конкретные произведения. Долгое время разные секции оркестра — «струнные» для текста, «духовые» для изображений — играли по своим партитурам. Но главный тренд 2025 года — это мультимодальность. Модели учатся понимать мир во всей его полноте, одновременно обрабатывая текст, изображения, аудио и даже видео. Это уже не просто отдельные секции, а единый, слаженный коллектив, способный, например, посмотреть на картинку и описать ее словами или сгенерировать видео по аудиодорожке.

Это не просто технологическая фишка, а ключевой драйвер роста всей индустрии. Согласно отчету Precedence Research, глобальный рынок мультимодального AI, который в 2025 году оценивается в $2,51 млрд, к 2034 году должен вырасти почти в 17 раз и достичь $42,38 млрд. Технически это достигается за счет сложных архитектурных решений, где, к примеру, иерархические признаки извлекаются из изображений и «вплетаются» в языковую модель через механизмы перекрестного внимания. Модель MLLaMA от Meta, использующая 32-слойный визуальный кодировщик, — яркий тому пример.

Давайте рассмотрим ключевые «секции» этого мультимодального оркестра.

Секция струнных (работа с языком)

- NLP (Natural Language Processing / Обработка естественного языка): Это общее название для всей группы технологий, которые позволяют компьютерам работать с человеческим языком. Это «скрипки, альты и виолончели» нашего оркестра.

- ASR (Automatic Speech Recognition) / TTS (Text-to-Speech): Это «уши» и «голос» системы. ASR преобразует вашу речь в текст (привет, Siri и Алиса!), а TTS — наоборот, озвучивает текст.

- NLU (Natural Language Understanding) / NLG (Natural Language Generation): Это «мозг» языковой секции. NLU отвечает за понимание смысла сказанного, извлечение сущностей и намерений. NLG, в свою очередь, отвечает за формулирование осмысленных и грамматически верных предложений.

Пример из практики: В марте 2025 года VK представил сервис AI Persona. Он использует большие языковые модели для создания детальных портретов аудитории для маркетологов. Система объединяет обезличенные данные сервисов VK с данными заказчика и, используя NLU, анализирует интересы и психографику сегментов. А затем, с помощью NLG, генерирует для каждого сегмента персонализированные рекламные сообщения. Это идеальный пример синергии NLP и больших данных для решения конкретной бизнес-задачи.

Секция духовых (работа с визуальной информацией)

- CV (Computer Vision / Компьютерное зрение): Зонтичный термин для технологий анализа изображений и видео. «Трубы, тромбоны и флейты» нашего оркестра.

- OCR (Optical Character Recognition): Конкретная и очень старая задача CV — «чтение» текста с картинок, сканов или фотографий. Когда вы сканируете документ и получаете редактируемый текст, это работает OCR.

- Генерация изображений: Самая модная сегодня часть CV. Модели вроде Midjourney, DALL-E и Stable Diffusion, которые «рисуют» картины по вашему текстовому описанию.

Дирижер (Data Scientist)

И над всем этим великолепием стоит человек — Data Scientist или ML Engineer. Это тот самый «дирижер», который выбирает нужные инструменты (модели и архитектуры), подбирает для них репертуар (данные), проводит репетиции (обучение) и анализирует итоговое звучание, решая, как сделать его еще лучше. Без этого специалиста самый мощный оркестр будет играть фальшиво и невпопад.

Экономика гигантов: Двойные стандарты AI

Мы восхищаемся возможностями GPT-4 или Claude 3, но редко задумываемся об их экономике. А она фундаментально меняет IT-ландшафт и живет по принципу двойных стандартов: астрономически дорогое обучение и стремительно дешевеющее использование.

- Цена обучения: Обучение одной большой фундаментальной модели — это колоссальные затраты. Оценки стоимости обучения GPT-4 варьируются от $60 до $100+ миллионов долларов, и это только расходы на вычислительные ресурсы. Эта реальность породила парадигму «фундаментальных моделей»: гиганты (OpenAI/Microsoft, Google, Anthropic) создают универсальные «электростанции», а остальные подключают к ним свои «приборы» через API.

- «Вычислительная бедность» и архитектурные прорывы: Казалось бы, это обрекает всех остальных на «вычислительную бедность», не оставляя шансов стартапам и академическим кругам. Но здесь в игру вступает архитектурная изобретательность. Ярчайший пример 2025 года — китайская модель DeepSeek R1. Согласно анализу Bruegel, она была обучена всего за $5,6 млн — в десятки раз дешевле западных аналогов (хотя по некоторым данным было потрачено $1.3 миллиарда). Секрет кроется в архитектуре Mixture-of-Experts (MoE), которая активирует только нужные части модели для конкретной задачи, делая ее невероятно эффективной. В статье «MiniMax-M1: Разбираем архитектуру, ломающую законы масштабирования» я рассказывал об архитектуре, которая позволяет моделям по-настоящему долго думать и работать с гигантскими объёмами данных.. В результате стоимость ее API на 93% ниже, чем у конкурентов, при сопоставимом качестве на многих задачах. Это доказывает, что умная архитектура может быть важнее грубой вычислительной силы.

- Обвал стоимости использования (инференса): И вот второй стандарт этой экономики. Если обучение — удел избранных, то использование моделей становится все доступнее. Согласно отчету AI Index Report 2025 от Stanford, стоимость вывода (инференса) для системы уровня GPT-3.5 упала в 280 раз за два года (с 2022 по 2024). Это стало возможным благодаря оптимизации алгоритмов, повышению энергоэффективности железа (на 40% ежегодно) и развитию более компактных, но мощных моделей с открытым кодом, которые почти догнали по качеству закрытые аналоги.

- Глобальные и локальные экосистемы: Эта экономика порождает не только глобальных гигантов, но и мощных локальных игроков. Российские компании активно строят собственные фундаментальные модели. Yandex в 2025 году представил YandexGPT с поддержкой контекста до 32 000 токенов, батч-режимом для обработки больших объемов данных и запустил программу Bug Bounty для своих AI-моделей. Sber демонстрирует впечатляющую окупаемость инвестиций в AI: по данным China Daily, каждый вложенный рубль приносит семь. Их модели GigaChat и Kandinsky доступны как open-source и получают международное признание, а Россия и Китай усиливают сотрудничество в области AI.

Тюнинг и апгрейд: Продвинутые концепции

Как сделать наш уже обученный «оркестр» еще более виртуозным, не переучивая его с нуля за сотни миллионов долларов? Для этого есть несколько изящных техник.

- Transfer Learning (Перенос обучения): Это, пожалуй, самая важная концепция для практического применения AI. Вместо того чтобы обучать модель с чистого листа, мы берем уже предобученную на гигантском датасете (например, на всем интернете) модель и лишь немного «доучиваем» ее на нашем небольшом, специфическом наборе данных. Аналогия: мы берем опытного пианиста-виртуоза и быстро учим его играть новую, конкретную мелодию. Ему не нужно заново учить нотную грамоту и ставить пальцы. Это экономит 99% времени и ресурсов.

- Edge AI (ИИ на устройстве): Традиционно вычисления происходят в облаке. Но иногда нужно, чтобы модель работала быстро, автономно и без отправки данных в интернет. Это и есть Edge AI. Модель оптимизируется так, чтобы работать прямо на вашем смартфоне, в камере или в автомобиле. Это как позволить «музыканту» играть соло прямо у вас дома, без связи с большим концертным залом. Классический пример — Face ID на iPhone. Вся обработка происходит на устройстве, что обеспечивает скорость и приватность.

- Federated Learning (Федеративное обучение): Удивительно элегантная идея, которая из экспериментальной технологии превратилась в признанный стандарт. Как улучшить модель для всех, не собирая ни у кого личные данные? В июне 2025 года Европейский супервайзор по защите данных (EDPS) выпустил официальный документ, в котором признал федеративное обучение полностью совместимым с GDPR и принципом privacy-by-design. Суть метода: каждый «музыкант» (смартфон) локально обучает свою копию модели на своих данных. Затем он отправляет в «центр» не сами данные, а лишь анонимное «обновление» — небольшую сводку о том, чему он научился. Центральная модель агрегирует тысячи таких обновлений и становится лучше для всех. Исследования показывают, что такой подход обеспечивает точность модели на уровне 91,2%, повышает успешность задач на 7,6% и снижает риски утечки данных на 41,5% по сравнению с централизованным обучением.

Заключение

Надеюсь, после этого путешествия карта мира AI стала для вас гораздо понятнее. Мы не просто прошлись по терминам, а увидели, как из базовых концепций (AI, ML, DL) вырастают методы обучения (с учителем, без, с подкреплением), которые воплощаются в конкретных архитектурах (нейросети, GANs) и технологиях (NLP, CV). Мы увидели, как эта технологическая пирамида опирается на фундамент из данных, железа и алгоритмов, и поняли, какие экономические силы формируют сегодняшний ландшафт.

Главный вывод, который я хочу, чтобы вы унесли с собой: искусственный интеллект — это не магия. Это результат десятилетий научной работы и недавнего идеального совпадения технологических, алгоритмических и экономических факторов. Понимание всей этой «карты» позволяет видеть не только хайп и возможности, но и реальную расстановку сил, ограничения и цену прогресса. Мы видим мир, где мультимодальность становится нормой, где стоимость обучения и использования моделей живет по разным законам, и где наряду с глобальными гигантами появляются мощные национальные AI-экосистемы.

Теперь, зная не только «что», но и «почему» и «какой ценой», вы можете гораздо более осознанно оценивать новости и продукты из мира AI. Проведите эксперимент: прямо сейчас посмотрите на свой смартфон. Какие из этих технологий уже работают на вас? Распознавание лица, подсказки при наборе текста, умная сортировка фото, голосовой ассистент... Оркестр уже играет. И теперь вы знаете, из каких инструментов он состоит.

Оставайтесь любопытными.